업스테이지가 자체 개발한 거대언어모델(LLM) '솔라 오픈 100B(솔라 오픈)'가 중국의 딥시크 등 글로벌 모델 대비 뛰어난 성능을 보이는 것으로 나타났다. 솔라 오픈은 정부가 주관하는 독자 인공지능(AI) 파운데이션 모델 프로젝트에 참가하는 업스테이지가 내놓은 결과물이다.

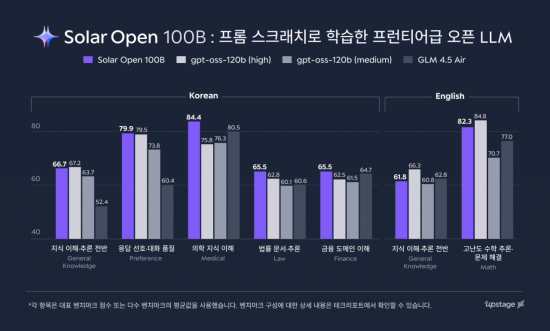

6일 업스테이지에 따르면 매개변수 1000억개(100B)급 모델인 솔라 오픈은 중국 딥시크의 AI 모델인 'R1(DeepSeek R1-0528-671B)'과 비교해 한국어(110%), 영어(103%), 일본어(106%) 등 3개 국어 주요 벤치마크 평가에서 앞서는 결과를 냈다. 솔라 오픈의 모델 크기는 딥시크 R1 대비 15%에 불과하다.

특히 한국어 능력이 글로벌 모델 대비 뛰어났다. 한국 문화 이해도(Hae-Rae v1.1), 한국어 지식(CLIcK) 등 주요 한국어 벤치마크 결과 딥시크 R1 대비 2배 이상의 성능 격차를 보였고, 비슷한 규모의 오픈AI 오픈소스 모델인 'GPT-OSS-120B-Medium'(GPT-OSS)과 비교해서도 100% 수준으로 앞서는 성능을 냈다.

수학, 복합 지시 수행, 에이전트 등 고차원적 지식 영역에서는 딥시크 R1과 대등한 성능을 확보했고, 종합 지식과 코드 작성 능력에서는 GPT-OSS와 비슷한 수준의 결과를 냈다.

업스테이지는 약 20조 토큰 규모의 고품질 사전학습 데이터셋 덕분에 이 같은 성과를 냈다고 설명했다. 업스테이지는 한국어 데이터 부족 문제를 해결하기 위해 합성 데이터와 금융·법률·의학 등 분야별 특화 데이터 등을 학습에 활용했다. 향후 해당 데이터셋의 일부를 한국지능정보사회진흥원(NIA)의 'AI 허브'를 통해 개방할 예정이다.

솔라 오픈은 129개의 전문가 모델을 혼합한 'MoE(Mixture-of-Experts)' 구조를 통해 실제 연산에는 120억개의 매개변수만 활성화하는 방식으로 효율성을 높였다. 여기에 그래픽처리장치(GPU) 최적화를 통해 초당 토큰 처리량(TPS)을 약 80% 향상시키고, 자체 강화학습(RL) 프레임워크 '스냅PO(SnapPO)'를 개발해 학습 기간을 50% 단축했다. 이를 통해 얻은 GPU 인프라 비용 절감 규모만 약 120억원에 달한다.

업스테이지는 솔라 오픈을 데이터 구축부터 학습까지의 과정 전반을 독자적으로 수행하는 '프롬 스크래치' 방식으로 개발했다. 업스테이지는 이 모델을 글로벌 AI 오픈소스 플랫폼 '허깅페이스'에 공개하는 한편, 개발 과정과 기술적 세부 내용을 담은 테크 리포트도 함께 발표했다.

김성훈 업스테이지 대표는 "솔라 오픈은 업스테이지가 처음부터 독자적으로 학습해낸 모델로, 한국의 정서와 언어적 맥락을 깊이 이해하는 가장 한국적이면서도 세계적인 AI"라면서 "이번 솔라 오픈 공개가 한국형 프런티어 AI 시대를 여는 중요한 전환점이 될 것"이라고 말했다.

이명환 기자 lifehwan@asiae.co.kr

▶ 2026년 사주·운세·토정비결·궁합 확인!

▶ 놓치면 손해! 2026 정책 변화 테스트 ▶ 하루 3분, 퀴즈 풀고 시사 만렙 달성하기!

![[포토] 폭설에 밤 늦게까지 도로 마비](https://image.ajunews.com/content/image/2025/12/05/20251205000920610800.jpg)

![[포토] 예지원, 전통과 현대가 공존한 화보 공개](https://image.ajunews.com/content/image/2025/10/09/20251009182431778689.jpg)

![[포토]두산 안재석, 관중석 들썩이게 한 끝내기 2루타](https://file.sportsseoul.com/news/cms/2025/08/28/news-p.v1.20250828.1a1c4d0be7434f6b80434dced03368c0_P1.jpg)

![블랙핑크 제니, 매력이 넘쳐! [포토]](https://file.sportsseoul.com/news/cms/2025/09/05/news-p.v1.20250905.c5a971a36b494f9fb24aea8cccf6816f_P1.jpg)

![[작아진 호랑이③] 9위 추락 시 KBO 최초…승리의 여신 떠난 자리, KIA를 덮친 '우승 징크스'](http://www.sportsworldi.com/content/image/2025/09/04/20250904518238.jpg)

![블랙핑크 제니, 최강매력! [포토]](https://file.sportsseoul.com/news/cms/2025/09/05/news-p.v1.20250905.ed1b2684d2d64e359332640e38dac841_P1.jpg)

![[포토] 국회 예결위 참석하는 김민석 총리](https://cphoto.asiae.co.kr/listimg_link.php?idx=2&no=2025110710410898931_1762479667.jpg)

![[포토]첫 타석부터 안타 치는 LG 문성주](https://file.sportsseoul.com/news/cms/2025/09/02/news-p.v1.20250902.8962276ed11c468c90062ee85072fa38_P1.jpg)

![[포토] 박지현 '아름다운 미모'](http://www.segye.com/content/image/2025/11/19/20251119519369.jpg)

![[포토] 발표하는 김정수 삼양식품 부회장](https://image.ajunews.com/content/image/2025/11/03/20251103114206916880.jpg)

![[포토] 김고은 '단발 여신'](http://www.segye.com/content/image/2025/09/05/20250905507236.jpg)

![[포토] 키스오브라이프 하늘 '완벽한 미모'](http://www.segye.com/content/image/2025/09/05/20250905504457.jpg)

![[포토] '삼양1963 런칭 쇼케이스'](https://image.ajunews.com/content/image/2025/11/03/20251103114008977281.jpg)

![[포토] 알리익스프레스, 광군제 앞두고 팝업스토어 오픈](https://cphoto.asiae.co.kr/listimg_link.php?idx=2&no=2025110714160199219_1762492560.jpg)

![[포토] 언론 현업단체, "시민피해구제 확대 찬성, 권력감시 약화 반대"](https://image.ajunews.com/content/image/2025/09/05/20250905123135571578.jpg)

![[포토] 박지현 '순백의 여신'](http://www.segye.com/content/image/2025/09/05/20250905507414.jpg)

![[포토] 김고은 '상연 생각에 눈물이 흘러'](http://www.segye.com/content/image/2025/09/05/20250905507613.jpg)

![[포토] 아이들 소연 '매력적인 눈빛'](http://www.segye.com/content/image/2025/09/12/20250912508492.jpg)

![[포토]끝내기 안타의 기쁨을 만끽하는 두산 안재석](https://file.sportsseoul.com/news/cms/2025/08/28/news-p.v1.20250828.0df70b9fa54d4610990f1b34c08c6a63_P1.jpg)

![[포토] 한샘, '플래그십 부산센텀' 리뉴얼 오픈](https://image.ajunews.com/content/image/2025/10/31/20251031142544910604.jpg)

![[포토]두산 안재석, 연장 승부를 끝내는 2루타](https://file.sportsseoul.com/news/cms/2025/08/28/news-p.v1.20250828.b12bc405ed464d9db2c3d324c2491a1d_P1.jpg)

![[포토] 키스오브라이프 쥴리 '단발 여신'](http://www.segye.com/content/image/2025/09/05/20250905504358.jpg)

![[포토] 아홉 '신나는 컴백 무대'](http://www.segye.com/content/image/2025/11/04/20251104514134.jpg)

![“현대차 전시장 갔는데 차가 없네?”…라스베이거스 집어삼킨 ‘로봇 군단’ [CES 2026]](http://www.segye.com/content/image/2026/01/07/20260107514800.jpg)

![[신년사]김택진·박병무 엔씨 대표 "성장·혁신으로 새로운 도약"](https://cphoto.asiae.co.kr/listimg_link.php?idx=2&no=2024032013292111238_1710908962.jpg)